Some time ago I started analyzing Blurt in terms of SEO. I scanned the platform with a crawler and examined the most common problems.

From this text you will learn the results of my research.

So the first question is how many people finding blurt by google?

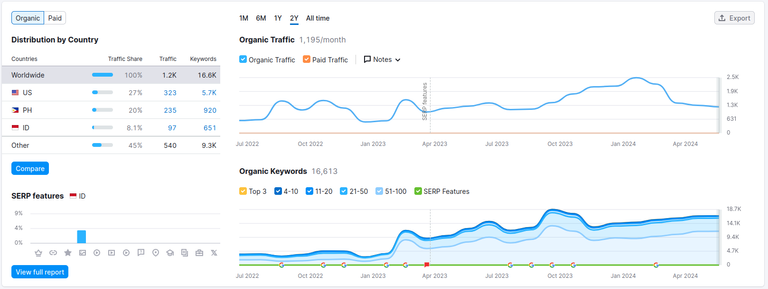

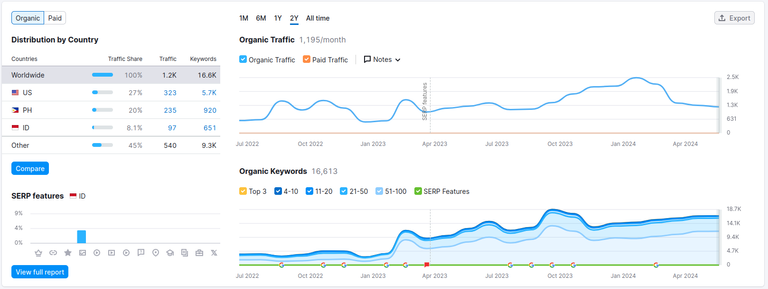

Using the semrush tool (which is free for single use, so anyone can repeat such a test) on the blurt blog domain, I received the following results:

As you can see from the attached screenshot, over the last year the number of visits per month has fluctuated around 1.2k, with the winter maximum around 2.52k.

The visit itself is not everything.

It is important how long visitors stay on the website, how many pages they view and how many people, when they come across some content at this address, simply say "meh" and run away.

By analysis tool:

Pages/Visits = 5.09 - which means that one user visits 5 pages on average

Avg. Visit Duration 10:32 - which means that an average visit lasts at least 10 minutes.

Bounce rate 35.40% - which means that only 35.4% of users turn back and run away ;]

This clearly means that, contrary to some people's beliefs, blurt has the potential to attract new users and retain them for longer. An average of 5 pages per session with a 10-minute stay means that the user spends on average 2 minutes on the displayed content, which is enough time to read average-length entries. We can therefore conclude that most users still read what they vote for, although they do not necessarily spend time commenting on it or engaging in discussions.

At this point, it is worth asking whether this is due to the fact that the visitors are logged in users. Or maybe a large part of these views are visits from unlogged users who might want to engage in the discussion, but the lack of an account dissuades them from doing so?

How many keywords in top search?

Currently, over 16,000 keywords that we can type into Google lead us to some of the content published via blurt, of which, unfortunately, only 15 are in the top 4 and only 176 in the top 10.

What could be the reasons for this?

The so-called SEO from our "favorite" corporation Google imposes several standards on us in order to kindly allow any of our websites to be at the top of the search lists, these are:

- content structure - it's about how the text is structured, i.e. whether it has h1, h2, etc. headings in the right order and whether it has them at all. How the keywords contained in the content correlate with the title and content, whether the images have the so-called "alt" descriptions, etc. The length of headings and title also matters. It should not exceed 70 characters.

- meta tags - i.e. a well-built short title, pages, and a short description

- originality of content - the more original content on a unique topic that is scarce on the Internet, the better for us. (unless it's something nasty and politically incorrect, then I may not index it at all :P). When something is pasted in many places and duplicated many times, it's not very nice.

- the quantity and quality of links and backlinks leading to and from our content - If our content also includes meaningful links to other websites on similar topics and our article is also shared in many places on portals with the so-called "high ranking". This is also good and it means that the content that contains the keywords for which Google positions it will be positioned higher than content similar to ours.

What did the analysis of the blurt.blog domain bring with the help of the so-called crawler that scans the entire domain and looks for potential problems?

Well, the biggest of them, in the context of what I wrote above, turns out to be the lack of h1 headers in our users' content. As many as 76% of the content does not have them.

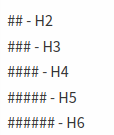

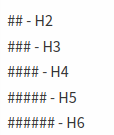

Therefore, I remind users that if they write something, it is worth using h1 and other headings in their content. This is done with markdown using this single character:

The next characters for heading levels in markdown are:

The correct heading structure is exactly 1 occurrence of H1. then it might look like this:

H1

some text

---- H2

some text

-------- H3

some text

------------ H4 etc..

some text

---- H2

some text

-------- H3

some text

------------ H4 etc..

some text

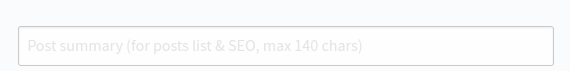

Another important issue is the use of the descriptions provided here:

Blurt is good for link building.

One more interesting thing I noticed while studying links in Google Search Console to other websites. Blurt works very well as a place to post backlinks to your own websites. They are easily noticed by Google search console, so they can have a positive impact on the SEO of our other domains.

To sum up:

As you can see, every platform on which we publish something is alive and searched thanks to the people who publish on it. That's why, despite all difficulties, it is worth blazing new trails and supporting the development of web3. 1.2k/month of views with such high involvement of visitors begins to be a sensible place that can be used for business and influencer purposes.

I also believe that you should not be discouraged by the lack of reactions or comments under your posts, because a large part of visitors may simply not be registered and do not know how to do it. Unfortunately, the lack of a view counter makes it impossible to track traffic on individual articles for now. However, these are problems for developers to solve in the future. It is the responsibility of investors and users to take care of the quality of the content they publish and actively encourage others to join the network as registered users and provide support in registration, which is unfortunately not very easy and intuitive at the moment.

That's it for now. In our next publication, I will try to make a comparison for other frontends and for sister blockchains ;)

Regards!

Jak wiele osób odwiedza blurt.blog oraz trochę o seo.

Jakiś czas temu zająłem się analizą Blurta pod względem seo. Przeskanowałem platforme crawlerem, zbadałem najczęściej wystepujące problemy.

Z tego tekstu dowiecie się jakie są wyniki moich dociekań.

Pierwsze pytanie jakie sobie zadałem to ile osób odwiedza blurta przez wyszukiwarkę google?

Używając narzedza semrush (które dla pojedyńczego użycia jest darmowe więc każdy może sobie powtórzyć takie badanie) na domenie blurt blog otrzymałem nastepujące wyniki:

Jak widać z załączonego screena, przez ostatni rok liczba odwiedziń w ciągu miesiąca wahała się tak w granicach 1.2k z maximum zimowym w okolicach 2,52k.

Same odwiedziny to nie wszystko.

Ważne jest jak długo odwiedzający zostają na stronie ile stron wyświetlają oraz ile osób trafiając na jakieś tresci pod tym adresem poprostu mówi "meh" i ucieka gdzie pieprz rośnie.

Wg narzędzia analitycznego:

Pages/Visits = 5.09 - co oznacza że jeden użytkownik średnio odwiedza 5 stron

Avg. Visit Duration 10:32 - co oznacza że przeciętna wizyta trwa przynajmniej 10 minut.

Bounce rate 35.40% - co oznacza że zaledwie 35.4% użytkowników robi w tył zwrot i ucieka ;]

Oznacza to ewidentnie że w brew przeświadczeniom niektórym blurt ma potencjał przyciągania nowych użytkowników i zatrzymuje ich na dłużej. Średnio 5 stron na sesję przy 10 minutach pobytu oznacza że użytkownik poświęca średnio 2 minuty na wyświetlaną treśc co jest czasem wystarczającym aby przeczytać średniej długości wpisy. Moża więc wnioskować z tego że większość użytkowników mimo wszystko czyta to na co głosuje chociaż nie koniecznie poświęca czas na komentowanie tego i wdawanie sie w dyskusje.

W tym miejscu warto zadać sobie więc pytanie czy jest to spowodowane tym że odwiedzającymi są zalogowani użytkownicy. A może dużą część tych wyświetleń stanowią wizyty niezalogowanych użytkowników którzy może i chcieli by wdać się w dyskusję jednak brak konta ich od tego odwodzi?

Jak wiele słów kluczowych mamy w topwych wyszukiwaniach?

Na dzień dzisiejszy ponad 16 k słów kluczowych które możęmy wpisać w google, dporpwadzi nas do którejś z treści opublikowanych za pośrednictwem blurt z czego niestety tylko 15 znajduje się w top 4 i zaledwie 176 w top 10.

Jakie są tego przyczyny?

Tak zwane SEO od naszej "ulubionej" korporacji google narzuca nam kilka standardów w związku z tym aby łaskawie pozwolić znaleźć się którejkolwiek z naszych stron na szczycie list wyszukiwania są to:

- struktura treści - chodzi o to jak tekst jest zbudowany czyli czy ma nagłówki h1 h2 itd w odpowiedniej kolejności i czy w ogóle je ma. To jak słowa kluczowe zawarte w treści koorelują z tytułem zawartością, czy obrazki mają tzw opisy "alt" etc. Długość nagłówków i tytułu tez ma znaczenie. Nie powinna ona przekraczać 70 znaków.

- metatagi - czyli dobrze zbudowany krótki tytuł, strony, oraz krótki opis

- oryginalność treści - im bardziej oryginalna treść na unikalny temat któego mało w necie tym lepiej dla nas. (no chyba żę to coś nieładnego i niepoprawnego politycznie wtedy możę się w ogóle nie zaindeksować :P). Jak coś jest przeklejone w wielu miejscach i zduplikowane wielokrotnie to z kolei bardzo nie ładnie.

- ilość i jakosć linków i backlinków prowadzących do naszej treści i z naszej treści - Jeśli z naszej treści wychodzą też sensowne linki do innych witryn o podobnej tematyce i nasz rtykluł też jest udostepniany w wielu miejscach na portalach o tzw "wysokim rankingu". To też jest dobrze i sprawia to że dana treść która zawiera dane słowa kluczowe na które pozycjonuje ją google, będzie pozycjonowana na wyższje pozycji od treści podobnych do naszej.

Co przyniosła analiza domeny blurt.blog z pomocą tzw crawlera który skanuje cąła domenę i wyszukuje potencjalne problemy?

Otóż największym z nich w kontekście tego co napisałem powyżej okazuje się być brak nagłówków h1 w treściach naszych użytkowników. Aż 76% treści ich nie posiada.

Uczulam więc użytkowników że jeśli coś piszą to warto używać w swojej treści nagłówków h1 oraz pozostałych nagłówków. Robi się to z pomocą markdown z użyciem tego pojedyńczego znaku:

Kolejne znaki dla poziomów nagłówków w markdown to:

Prawidłowa struktura nagłówków to dokładnie 1 wystapienie H1. nastepnie może to wyglądac tak:

H1

jakiś tekst

---- H2

jakiś tekst

-------- H3

jakiś tekst

------------ H4 etc..

jakiś tekst

---- H2

jakiś tekst

-------- H3

jakiś tekst

------------ H4 etc..

jakiś tekst

Kolejną ważną kwestią jest stosowanie opisów które zamieszczamy tu:

Blurt dobry dla linkbuildingu

Jeszcze jedna ciekawostka jaką zauważyłem studiując linki w google search console do innych stron. Blurt bardzo dobrze działa jako miejsce w którym sprawdza się zamieszczanie backlinków do własnych stron internetowych. Są one z łatwością odnotowywane przez google search console, przez co moga pozytywnei przełoży się na seo innej naszej domeny.

Podsumowując:

Jak widać każda platforma na której coś publikujemy żyje i jest wyszukiwana dzięki osobom które na niej publikują. Ot dlaczego mimo wszelkich trudności warto przecierać nowe szlaki i wspierac rozwój web3. 1.2k/ miesiąc wyświetleń przy tak dużym zaangażowaniu odwiedzających zaczyna być sensownym miejscem które można zacząć wykorzystywac w celach buisnesowych oraz influencerskich.

Uważam też że nie należy się zrażać brakiem reacji czy też komentarzy pod swoimi postami ponieważ spora część odiwedzających może najzwyczajneij w świecie nie być zarejestrowana i nie wiedzieć jak to zrobić. Brak licznika wyświetleń niestety póki co uniemożliwia śledzenia ruchu na poszczególnych artykułach. Są to jednak problemy do rozwiązania w przyszłości przez developerów. Po stronie inwestorów i użytkowników leży to aby dbac o jakość publikowanych przez siebie treści oraz aktywnie zachęcać innych do dołączania do sieci jako zarejestrowanych użytkowników a także służęnia wsparciem w rejestracji króra póki co niestety nie jest zbyt łatwa i intuicyjna.

To tyle póki co. W naszepnej publikacji postaram się zrobić porównianie dla innych frontendów oraz dla siostrzanych blockchainów ;)

Pozdrawiam

lololl - 1.2 k per month! seriously?...lol ( I took that to mean per day..oops)

Personal blogs get waaaaaaaaay more traffic per month than that.

In fact, nearly as much per day...

I would never back link to my other places in web 2, on any dpos,.

(it'd be like inviting an old girlfriend who turned out to be nuts and wish to forget, into your friends house!lol))

There's a saying in English 'there's no point flogging (beating) a dead horse'.

Looks like 'this horse', is at the purification stage.

How anyone could ever expect a different outcome ?

Using the voting patterns, lack of interest/support in quality posts, and the also very obvious lack of competence from those who have more blurt power than they do brain cells, as a metric.

(well, not really a surprise, to be honest. It was very apparent from way back in the steem days , pre-hive fork...)

...and yes, I still have my own reasons to be here.

(hint....it's not for promoting web3.

0shite).This is the estimated number of ORGANIC searches, i.e. searches in which someone entered a phrase into Google and found a blurt.

In addition, you still have direct entries by entering the address or reloading the tab in the browser, and entries from links in social media and entriest from other domains like https://blurt.pl for example. This is NOT total traffic. The statistics for total traffic are kept by the person who hosts the blurt blog and has access to Google analytics, in this case, as far as I know, @megadrive.

And there is also lnly for blurt.blog without beblurt. blurt.intinte.org blurt one etc...

btw If we had 1.2k per day here, i.e. 36k per month, you wouldn't have anything to complain about because you would have at least a few new faces every day :P

I have always wondered how well Blurt did in SEO thanks for the analysis. I also wonder if #tags were used with actual keywords if that would help search engine traffic at all. Most of the #tags used are for some community or curator and not the subject of the post or related keywords.

These tags are not added as meta keywords tag from what I can see:

Moreover, the keywords meta tag is no longer as important as it used to be, because nowadays SEO is based on AI and the crawler itself detects the keywords it deems important.

Re🤬eD

AWESOME! 👏

🥥

Great information, keep it coming 🖖

To jest to, o czym trąbiłem wiele razy, wielokrotnie szukając schematu w kilku treściach. Blockchain daje przewagę i jeszcze daje, a jak będzie, ze sztuczną to czas pokażę. Tak było na steem, moja strona weszła do top w goog do trójki 3m pod frazą...sok linka. Jeszcze jeden mały szczegół moc konta daje plus tylko w uderzenie twojego postu bo przesuwa treści o kilka nawet stron. Dwujęzyczny post jest na szkodę bo co gdzie ma być i pod jaką frazą roboty nie łapią? Jak już to dwa osobne przetestuj za parę tygodni sprawdź co gdzie.

Plandemia jest przykładem wybuchu wielu kanałów na zdecentralizowanych platformach...teraz wielu pokutuje z wielkimi spadkami, bo nikt ich nie poleca. Hostingi jadą z dodatkami Al więc będzie walka al vs al. Ale jest rozwiązanie i przewaga i je znasz...aktywność panie bo samo nie przyjdzie. Testowałem wiele kanałów wyrzucając post w przestrzeń staty rosną.

Myślisz że dlaczego tu się kiszę...w pewnym momencie wpadną strony. Domeny paroletnie zabukowane mocną obecnie frazą. Przypomnę ci steema...😂

tzn jesli chodzi o steema to bije na głowę hive jesli chodiz o wyswietlenia wciąż. Niemniej zgadza się ogólnie widac tend ze socialmedia i google kierują się w kierunku płatnego pozycjonowania i płatnych subskrypcji za dostęp.

Np na yt coraz ciężej coś oglądać za darmo bez frustracji bo jak ci nie wyskoczy w połowie np słuchania muzyki reklama to wyskakuje ci komunikat "czy oglądać dalej" a jak nie to to z kolei ścieżka zamiast po skorelowanych utworach ucieka wciąż do tych promowanych. Wyższa jakość filmów tez zarezerwowana tylko dla premium.

Tak samo masz z x.com że bez premium ciężko... FB już oficjalnie informował że jeśli nie chcesz aby zbierał twoje dane to musisz płacić za premium.

Google z kolei robi wszystko żeby promować tylko wielkie strony wielkich serwisów najlepiej tylko za kasę a zdobywanie tzw Organic traffic wiąże się z coraz wyższą poprzeczką do przeskoczenia.

Wniosek nasuwa się sam lada moment nie tylko będziesz oddawał dane o swoich zachowaniach oraz swoje publikacje na rzecz dużych graczy ale jeszcze będziesz za to płacił.

Tym czasem tu wszyscy mają okazję w mniejszym lub większym stopniu uczestniczyć w zysku platformy ;]

Tak i chwili powrotnej weny też wrócę przykład to Ator dalej kotwiczy link i reklamuje bo klik w link podtrzyma yt wyszukiwarkach. Hiv też ma potencjał i sami wprowadzili posty pod al z gpt PeakD ale sami sobie strzelą bo wchodzą al wykrywacze które będą zaniżać kopie i generowane przez al w wyszukiwarkach. Problem i go znasz to opłacone grupy i rabujące i kneblujące treść. Obserwowałem jak klipy nagle dostawały z automatu łapy w duł ibana na yt.

To się zgadza szczególnie po zmianie skryptów goog i oparte na sztucznej...na razie dwa blokery załatwiają Stands AdBlocker, jeszcze załatwia wszystko. Dobrze zmienić wyszukiwarkę, bo googlowska jest strasznie podrasowana pod wszystkie aplikacje i produkty. Nowe konto z automatu zaciąga dane, synchronizacje wszystko od wyświetlania numeru tel w wyszukiwarkach po wszelkie dane i masówka reklam. Zmiana wyszukiwarki w goog pomaga, ale nie załatwia wszystkiego... problem zaczynają mieć też zdecentralizowane przeglądarki, ale cisną jeszcze dalej Brave, Decentr

To było do przewidzenia, że będą szli w tym kierunku, bo o to chodzi Twitter już portfele opróżnia czas na Facebooka. to dopiero początek co szykują social, a Kowalski będzie latał jak we mgle, myśląc że rozmawia z człowiekiem. Widzisz, co się wyprawia n X, masowe boty i przejmowane konta. Przekierowanie do Telegramu przez masówki, zaczyna ludziom brzydnąć, przez zmasowane boty zaczynające się wymysły w postaci subskrypcji w tokenach to tamto byle doić i będzie szum jak z Brave- klapa i brak rozwoju. Teraz moda na TikToka który coraz bardziej zmienia regulaminy i wali cenzurą i blokadami ale to tylko specjalne pędzenie mas do chwili wdrożenia wszystkich mechanizmów Face i Goog potem nastanie silna cenzura i powrót owieczek .

Już tak jest za dodatki i rzekomy zarobek z du..... płacisz premium, ledwo się ludziom zwraca do wartości wysiłku niewarte. Ale Kowalski dostaje bon do wykorzystania w danym punkcie i jest git. Znaczek ikona premium daje poczucie wartości. Dane z fejsa połączone z bankami i zaczyna być warunkiem weryfikowanego konta...rzekomo ułatwiające weryfikację w pseudo bankach i zarazem sprawdzenia, czy nie masz czasem sprzecznego nastawienia do tematu.

Na cenzurę bat...

https://www.privacytools.io/private-search

web2 support, nawet bez wysokich nagrod oplaca sie wrzucac tu linki

tyle żeby były to przynajmniej jakoś opisane linki. jest jeszcze coś takiego jak to:

Jak ten współczynnik jest niższy niż authority score dla naszej domeny to taki linkbuilding może negatywnie wpływać na nasze seo zamiast pozytywnie.

A to oczywiście współczynnik który zależy min od oryginalności contentu:

Na blurt blog jak widać póki co właśnie natural profile czynnik zarobił 21 punktów.

najkorzystniej dla blurta by było każdy post który jest spamem albo plagiatem oznaczać jako noindex żeby authority score było jak największe co nie przeszkadza zrobić na blurcie serwisu do linkowania bo np taki serwis jak panorama firm też ma wysokie AS chociaż jest tylko katalogiem profili firm:

wyszukiwarka google działa na tej samej zasadzie co wyszukiwarka youtube,- musisz być ręcznie zatwierdzony by załapać się na te wszystkie algorytmy i coś z tego mieć. Na youtube jest check mark, na google ten check mark jest niewidoczny, ale jest

No z tego co ja wiem to się mylisz w tym teracie. To działa tak że masz tzw "pająka" czyli crawlera który skanuje cały czas wszystkie domeny. Jak je zeskanuje to potem AI analizuje treść i dodaje je jako zaindeksowane pod konkretnymi hasłami z konkreną treścią jaką znaleziono w momencie zaindexowania i w zależności od tego co zeskanuje to nadaje jakieś tam wagi konkretynych słów kluczowych pokojarzonych z treścią na bazie tego co "zrozumiało" AI i kojarzy też z tzw intencjami słów kluczowych w koorelacji do treści. Czyli np jak zaindeksuje żę dla danego artykułu słowo kluczowe kaczka odnosi się do sprzedawanej kaczki to nadaje intencję zakupową dla słowa kaczka i jeśli user użyje np frazy: "kaczki na sprzedaż" to wyświetlają mu sie wszystkei te artykuły które maja zaindekoswane słowo kluczowe kaczka z intencją sprzedażową.

To tak w uproszczeniu. ale ten proces trwa długo i czasem strona nie bedzie zindeksowana nawet po miesiącu.

Ale ten proces można też przyspieszyć ręcznie jak dodasz swoja domene do google search console i tam ręcznie można zaindeksować każdy link. I przy takim do dawaniu od razu ci pokazuje czy strona nadaje sie do zaindeksowania a jak nie to pokazuje błędy dlaczego. Ja tak zawsze robię dla swoich domen i już nastepnego dnia dana strona ma wyświetlenia w wynikach wyszukiwania. A jak sie nie nadaje to wiem co poprawić na stronie żeby weszło.

To tylko teoria. Przypomnij sobie co się działo gdy google zakupił youtube. Na każdy wyszukiwany keyword w pierwszej 10 pojawiało się 6 linków do youtube. Wszystkich zalewała krew. Teraz jest jeszcze gorzej, jeżeli nie jesteś lewakiem, albo dużą poprawną politycznie korporacją to google ci nie pomoże

Zawsze było tak że robogoogle adorował swoje produkty. Można złamać wiele fraz ale nie obejdzie się bez bana i przestawienie skryptów YT. Ale to masa roboty- no teraz jest Al ukróca 70% fatygowania się.

To się zgadza przykładem reklamy nagle masa o krypto które dają kliki a to przekłada się na rynki bo są oparte na przeglądarkach. To samo było z reklamą treści szczypawic i wszelkich leków. Nie tylko działa na sprzedaż ale na giełdy...

warto też do Bingo to podstawa

Czy jest możliwe wprowadzić osobno dla spamu i kopi noindex? To by bardzo mocno wzmocniło pozycje nie tylko dla Blurt ale i poboczne roboty pająki by oszalały

Dobre pytanie. w tradycyjnej stronie atrybut noindex zostaje dodawany do linków tworzonych przez serwis i zapisywany w bazie danych. Pytanie jak to się ma od frontendów? może @fervi wie?